Глава 1. О поисковых системах

Несколько слов о поисковых системах!

Для того чтобы уметь грамотно оптимизировать и продвигать сайты в поисковых системах (далее – ПС), нужно понимать как они работают.

Это даст нам базовые понятия для дальнейшей работы. Я не буду рассказывать, как создавались первые поисковики, как они работали, что учитывали, я просто коротко опишу как они работают сейчас (в последние несколько лет).

На данный момент в мире много поисковых систем, но нас интересует именно «рунет». На его просторах действует тоже немало крупных компаний, но из них наиболее крупными, так называемыми лидерами, являются Яндекс и Гугл. На первом месте стоит Яндекс, а второе занимает Гугл (конечно, когда мы в учет берем именно Россию). Третье место принадлежит поисковой системе Майл, но отставание от лидеров достаточно существенное.

Как работают Поисковые системы?

Я как можно сжато объясню, как же работают поисковые системы, что поможет понять, какие действия полезно совершать, а какие нет.

Первый этап – это распознание новых страниц или сайтов. Если появились новые документы, о них должна как-то узнать ПС, чтобы работать с ними. Сам вебмастер может сообщить Поисковой системе о новом сайте, посредством специализированных систем (в Яндексе она называется Яндекс Вебмастер, а в Гугле – search console), Достаточно добавить новый сайт или страницу туда, и ПС узнает о их существовании.

Второй способ – это распознавание нового сайта с помощью сервисов собственной аналитики (у Гугла такой сервис называется Гугл Аналитикс, а у Яндекса – Яндекс Метрика). Когда эти коды добавляются на сайт, поисковая система узнает о новом сайте и страницах. Распознаванию помогает также и поведения пользователей.

Третий способ это – распознавание с помощью собственных браузеров. У Яндекса это Яндекс браузер, а у Гугла – это Гугл Хром. Когда какой-то пользователь зашел на эту страницу с помощью указанных браузеров, то соответствующая ПС узнает о новой странице.

И четвертый способ – это ссылки, как внутри сайта, где с одной проиндексированной страницы робот по ссылке пойдет на другую новую страницу и внешние ссылки, когда робот идет на сайт из других источников и таким образом индексирует его.

После этого идет этап парсинга или сканирования, после сканирования всех текстов в странице, робот добавляет ее в свой индекс, а какое количество страниц робот проиндексирует в первый раз по большей части связано с размерами сайта, его скоростью и качеством конкретных страниц.

После чего уже идет этап упорядочивания станиц в выдаче или ранжирование. Для ранжирования поисковики используют несколько сотен факторов. В результате поиска страницы показываются в специальных блоках, которые называются сниппетами.

В обычном сниппете бывает заголовок страницы, краткое описание страницы и ссылка на данный документ, а вообще, в зависимости от тематик, там может быть и картинка, видео, звездочки и т. д. После этого поисковики всегда анализируют выдачу, нравятся данные сайты пользователям или нет, с помощью нескольких факторов. Один из основных это поведенческий. Под ним понимается самый простой способ узнать это с помощью сервисов аналитики или бразуеров, а так же поведенческие факторы дают оценку сайтов и документов.

Еще выделяются ассесоры поисковых систем, у которых есть конкретный чек лист по котоpому они оценивают, а также ссылки и другие факторы.

Как ПС понимает запрос

Нужно понимать, как оценивает сама поисковая система запрос пользователя, он должен как можно лучше понят информационную потребность пользователя, что хочет видеть конкретный пользователь, который набрал запрос.

Они вначале понимают тематику запроса, запрос про рецепты или про бытовую технику, или вообще про мультики, и в каждой тематике возможны свои нюансы при показе выдачи, это как для отдельных пользователей, так и в общем. Например, про рецепты в сниппетах показываются еще картинки или даже видео, в сайтах кинотеатров могут показываться одни ближайшие кинотеатры и т. д.

Потом он должен понять, витален этот запрос или нет. Например, человек ищут сам сайт самсунг и простo пишет самсунг, а значит этот запрос витален и показывается пользователю сайт самсунга на первом месте.

Потом он понимает информационный данный запрос или коммерческий, или вообще общий запрос (в этом случае он показывает различные блоки ответов – например, один сайт коммерческий, другой – информационный).

После чего есть геозависимость запроса: локальный он или нет – например, когда человек из Краснодара пишет запрос кафе, то ему показываются ближайшие кафе.

Персонализированная выдача – это поисковая выдача для определенных групп или определенных пользователей.

Поисковик с помощью своих сервисов (браузер, аналитики и т. д.) собирает информацию о пользователях и использует ее для составления более точной выдачи для всех.

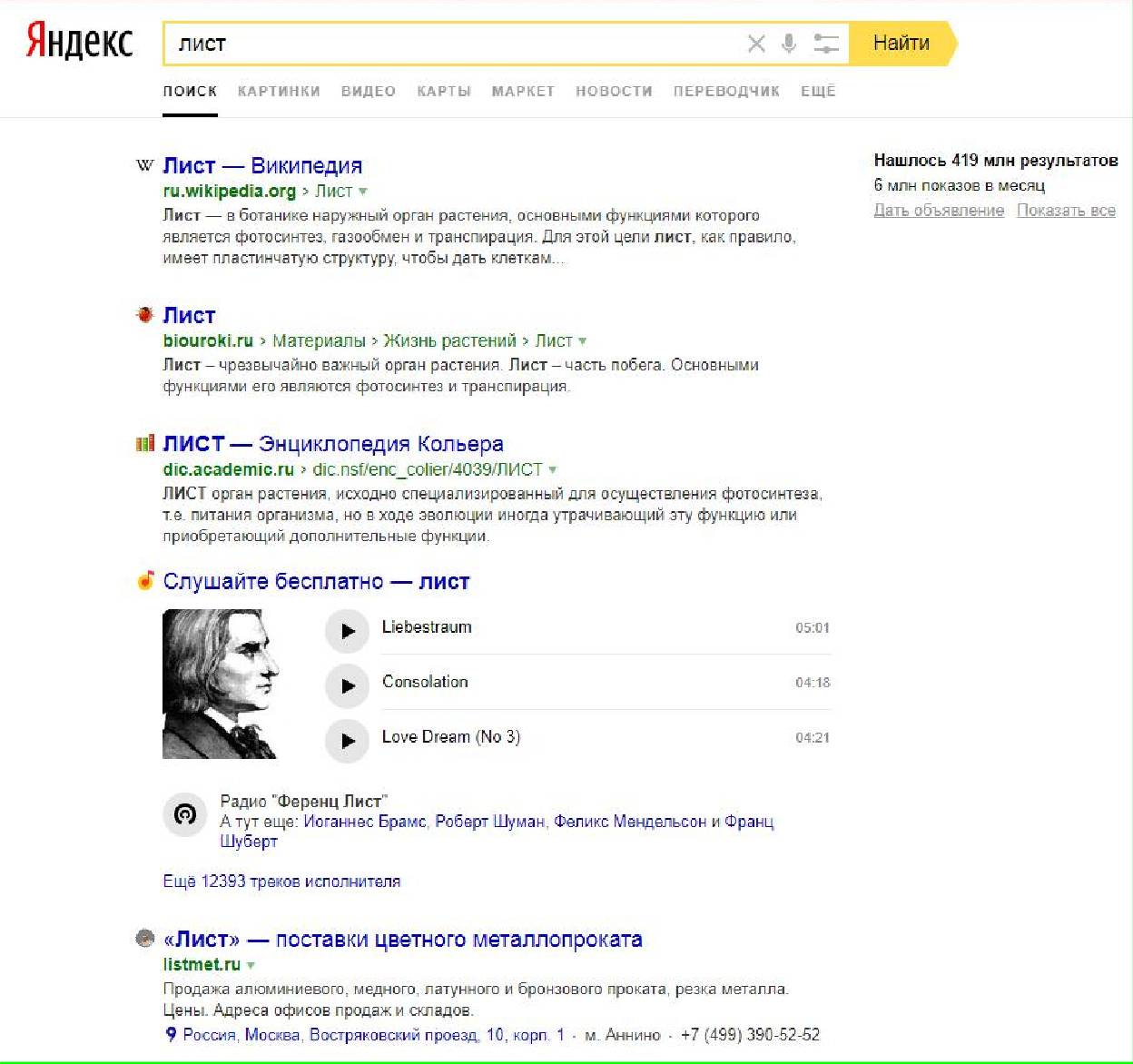

Значит, если вы любите фильмы и часто ищите их в поиске, то в вашем случае, если вы будете набирать запрос «лист», то поисковик вам будет показывать кино сайты, которые содержат в себе фильм «лист». А если вы любите чай, то поисковик покажет интернет магазины с товарами, в которых есть слово «лист» или информацию про «чайный лист». В том случае, если вы ценитель музыки, то музыкальные сайты, которые содержат песню группы «Лист» или информацию про них будут вам предложены в ответ на такой запрос.

Так же здесь показываются любимые сайты (сайты, на которые вы чаще всего заходите).

Вот так работает персональная выдача. Яндекс и Гугл используют ее в своих коммерческих целях, для показа контекстной рекламы более точной аудитории, что дает возможность больше зарабатывать, потому что клики растут.

Получается, что у всех поисковых систем есть свои алгоритмы (у самых крупных они точно есть), по которым они строят выдачу. Задачей нашего SEO является влиять на все эти этапы (точнее не на все, а на те, которые мы знаем). Но с этим не нужно перебарщивать, не нужно забывать об алгоритмах поисковых систем, которые могут вводить штрафные санкции.