II Используемые поисковыми системами методы. SEO как маркетинговая стратегия. Международные рынки. Юридические прецеденты

2.1 Получение индексации. Запрещение сканирования

Получение индексации

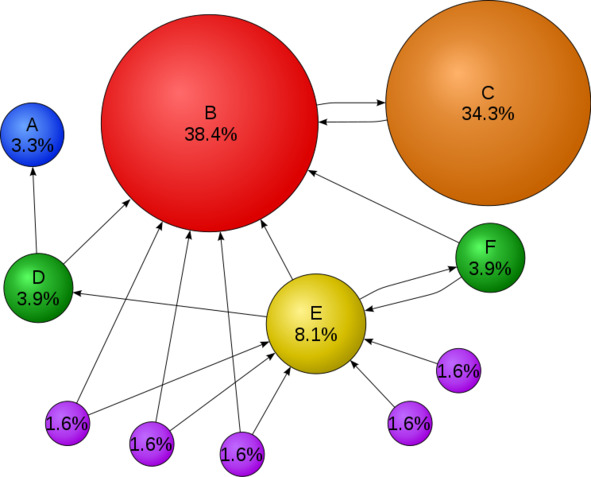

«На этой диаграмме, где каждый кружок представляет собой веб-сайт, программы, иногда называемые поисковыми роботами, проверяют, какие сайты ссылаются на какие другие сайты, со стрелками, представляющими эти ссылки. Веб-сайты, получающие больше входящих ссылок или более сильные ссылки, считаются более важными и являются тем, что ищет пользователь. В этом примере, поскольку веб-сайт B является получателем многочисленных входящих ссылок, занимает более высокое место в веб-поиске. И ссылки „проникают“, так что сайт C, даже если он имеет только одну входящую ссылку, имеет входящую ссылку с очень популярного сайта (B), а сайт E – нет. Примечание: проценты округлены». Источник: https://en.wikipedia.org/wiki/Search_engine_optimization

Поисковыми системами используются сложные математические алгоритмы – в целях интерпретации того, какие веб-сайты ищутся пользователями.

Такими ведущими поисковыми системами, какими в настоящее время являются Google, Bing и Yahoo!, для поиска страниц в результатах алгоритмического поиска используются краулеры (поисковые роботы, или веб-краулеры).

Страницы, на которые ведут ссылки с других проиндексированных поисковыми системами страниц, не нужно представлять, поскольку их находят автоматически. Yahoo! _ Directory и DMOZ, – это крупные каталоги, закрывшиеся в 2014-м и в 2017-м годах соответственно, требующие редакторской проверки человеком и ручной подачи.

Google предлагает (в дополнение к своей консоли отправки URL) Google Search Console, для нее можно бесплатно создать и отправить XML Sitemap, чтобы гарантировать, что все страницы будут найдены, особенно страницы, которые нереально обнаружить, автоматически переходя по ссылкам.

Прежде Yahoo! предоставлял платные услуги по отправке, гарантировавшие сканирование за стоимость клика; однако в 2009-м г. эта практика прекратилась.

При просмотре веб-сайта поисковые машины могут учитывать множество различных факторов. Поисковыми системами индексируется не каждая страница. Удаленность страниц от корневого каталога сайта также может являться фактором, влияющим на то, будут ли страницы проиндексированы.

Год 2016-й (ноябрь). Это было время объявления Google о серьезных изменениях в способе поиска веб-сайтов и начала действия его индекса mobile-first, это означает, что мобильная версия данного веб-сайта становится отправной точкой для того, что Google включает в свой индекс.

Год 2019-й (май). Это было время обновления Google движка рендеринга своего сканера до последней версии Chromium (74 на момент объявления).

Google было указано, что он будет обеспечивать регулярное обновление движка рендеринга Chromium до последней версии.

Год 2019-й (декабрь). Это было время начала обновления Google строки User-Agent своего краулера – ради отражения последней версии Chrome, используемой его службой рендеринга. Здесь наблюдалась задержка, вызванная необходимостью дать вебмастерам время на обновление кода, реагирующего на определенные строки User-Agent ботов. Google провел оценку и был уверен, что влияние окажется несущественным.

Год 2016-й (ноябрь). Это было время объявления Google о серьезных изменениях в способе поиска веб-сайтов и начала действия его индекса mobile-first, это означает, что мобильная версия данного веб-сайта становится отправной точкой для того, что Google включает в свой индекс. Сегодня, как мы знаем, большинство людей осуществляет поиск в Google с помощью мобильных устройств.

Год 2019-й (май). Это было время обновления Google движка рендеринга своего краулера до последней версии Chromium (74 на момент объявления). Google было указано, что он станет обеспечивать регулярное обновление движка рендеринга Chromium до последней версии.

Год 2019-й (декабрь). Это было время начала обновления Google строки User-Agent своего краулера – ради отражения последней версии Chrome, используемой его службой рендеринга. Здесь наблюдалась задержка, вызванная необходимостью дать вебмастерам время на обновление кода, реагирующего на определенные строки User-Agent ботов. Google провел оценку и был уверен, что влияние окажется несущественным.

Запрещение сканирования

В целях избежания нежелательного индексирования какого-то контента, веб-мастер может запретить поисковым роботам сканировать определенные файлы или каталоги – через стандартный файл robots. txt в корневом каталоге домена. Помимо этого, страницу можно явным образом исключить из базы данных поисковика (поисковой системы). Это делается с помощью специального метатега для роботов (как правило, – ).

Когда поисковая система посещает веб-сайт, файл robots. txt, – это первый, расположенный в корневом каталоге просканированный файл. Затем файл robots. txt подвергается анализу и роботу указывается, какие страницы сканировать не следует. Поскольку сканер поисковой системы способен хранить кэшированную копию данного файла, он может иногда сканировать те страницы, которые веб-мастер подвергать сканированию не желает.

Обычно запрещенные для сканирования страницы – это страницы, связанные с входом в систему, такие как корзины покупок и такой пользовательский контент, как результаты внутреннего поиска.

Год 2007-й (март). Это было время предупреждения Google вебмастеров, что им следует запретить индексацию результатов внутреннего поиска, так как эти страницы считаются поисковым спамом.

Год 2020-й был годом закрытия Google стандарта и открытия своего кода. И в настоящее время Google рассматривает его не в качестве директивы, а в качестве подсказки. Для надлежащего гарантирования того, что индексации страниц не произойдет, необходимо включение метатега робота на уровне страницы.

2.2 Повышение заметности веб-страницы в результатах поиска. Элементы для SERP, которым в последнее время Google уделяет больше внимания

Повышение заметности веб-страницы в результатах поиска

Уровень заметности веб-страницы в результатах поиска можно повысить с помощью различных методов. Этого повышения можно добиться с помощью перекрестных ссылок между страницами одного и того же веб-сайта ради предоставления большего количества ссылок на являющиеся важными страницы.

Источник: https://clck.ru/dWJpD

Заметность страницы обеспечивается также дизайном страницы. Из-за хорошего дизайна пользователи больше доверяют веб-сайту, желая остаться на нем после его нахождения. Если же люди покидают веб-сайт, это считается действием против веб-сайта и влияет на доверие к нему.

Еще повышение заметности веб-страницы в результатах поиска зависит от написания контента, включающего часто используемые ключевые фразы, чтобы обеспечилось его соответствие широкому кругу поисковых запросов и проявлялась тенденция к увеличению трафика.

Рекомендуется в целях учащения сканирования контента поисковиками (поисковыми системами) обеспечивать регулярное обновление контента. Это способно придать веб-сайту дополнительный вес.

Если вы добавите релевантные ключевые слова в метаданные веб-страницы, включая тег заголовка и метаописание, вы добьетесь повышения релевантности результатов поиска на сайте и увеличения трафика.

Канонизация URL -адресов веб-страниц, доступных через ряд URL-адресов, с использованием элемента канонической ссылки либо с помощью переадресации 301, может помочь убедиться, что все ссылки на разные версии URL-адреса учитываются в рейтинге популярности ссылок страницы. Данные ссылки известны в качестве входящих, указывающих на URL-адреса. Они могут приниматься во внимание в рейтинге популярности ссылки на страницу, влияя на уровень доверия пользователей к веб-сайту.

Элементы для SERP, которым Google уделяет в последнее время больше внимания

Кроме прочего, в последнее время Google уделяется больше внимания нижеперечисленным элементам для SERP (позиции в рейтинге поисковой системы). Это следующие элементы [1]:

«Версия HTTPS (защищенный или безопасный сайт).

Скорость страницы.

Структурированные данные.

Мобильная совместимость

AMP (ускоренные мобильные страницы)

BERT».

2.3 Категории техник SEO

Возможно подразделение техник SEO на две широкие категории: техники, рекомендуемые поисковыми системами как часть хорошего дизайна («белые шляпы»), и техники, не одобряемые поисковыми системами («черные шляпы»).

Поисковики стремятся к сведению к минимуму влияние последних, включая спам-индексирование. Отраслевые обозреватели классифицировали данные практики и использующих их практиков либо как белое SEO, либо как черное SEO.

Что касается «белых шляп», они, как правило, дают сохраняющиеся в течение длительного времени результаты, результаты же «черных шляп» приводят к ситуации блокировки веб-сайтов – либо временно, либо навсегда, – как только поисковые системы узнают о них.

Белая техника SEO

Источник: https://clck.ru/dnfYk

Техника SEO считается «белой шляпой» в случае, если она не содержит обмана, следуя рекомендациям поисковых систем. Правда, стоит отметить, что эти рекомендации не являются написанными в виде заповедей или набора правил.

Белое SEO отличается не только тем, что при его реализации обеспечивается следование рекомендациям, но достигается, чтобы контент, который поисковая система индексирует и впоследствии ранжирует, являлся тем же контентом, который увидит пользователь.

Рекомендация для «белой шляпы» обычно сводится к созданию контента не для поисковых систем, а для пользователей, а также к тому, чтобы сделать данный контент легко доступным для онлайн-алгоритмов «пауков», а не стремиться к обману алгоритма с целью получения лучшего индексирования и ранжирования.

Белое SEO во многом схоже с веб-разработкой, способствующей доступности, хотя нельзя говорить об их идентичности.

Черная техника SEO

Источник: https://aliexpress.ru/item/33052098771.html

В отношении черной техники SEO можно сказать, что имеет место ее стремление к улучшению рейтинга не одобряемыми поисковыми системами способами, или с использованием такой вещи, как обман.

В одной из техник «черной шляпы» практикуется использование скрытого текста, либо в виде текста, окрашенного аналогично фону, либо текста за пределами экрана, либо в невидимом div.

С помощью другой техники «черной шляпы» достигается маскировка – она выдает разные страницы в зависимости от того, запрашивается страница поисковой системой либо посетителем-человеком.

Серая техника SEO

Источник: https://clck.ru/drLSt

Есть еще одна (промежуточная) техника, к использованию которой иногда прибегают., – это серая техника (или «серая шляпа») SEO. Она представляет собой нечто усредненное между техниками «белой шляпы» и «черной шляпы». О ее использовании говорят, когда не всегда происходит наказания веб-сайта, но не наблюдается создания наилучшего контента для пользователей. Серое SEO сосредоточено лишь на достижении цели улучшения рейтинга в поисковых системах. Интересы пользователей при этом игнорируются.

Веб-сайты, использующие черные или серые техники, могут наказываться поисковыми системами при обнаружении этого использования. Наказанием может служить снижение их рейтингов, либо полное удаление их из списков своих баз данных. Возможно применение наказание автоматическое (алгоритмами поисковых систем) либо путем ручной проверки веб-сайта. Один из примеров – удаление в 2006-м году (в феврале) Google как Ricoh Germany, так и BMW Germany – за использование обмана. Обе эти компании, однако, оперативно принесли извинения, исправили проблемные страницы и были восстановлены на странице результатов Google-поисковика.

2.4 SEO как маркетинговая стратегия. Международные рынки. Юридические прецеденты

SEO как маркетинговая стратегия

SEO не рассматривается как интернет-маркетинговая стратегия, являющаяся самой подходящей абсолютно для каждого веб-сайта, можно в некоторых случаях добиться даже большей эффективности с помощью других интернет-маркетинговых стратегий. К примеру, более эффективной может оказаться (в зависимости от целей оператора веб-сайта) платная реклама PPC (осуществляемая с помощью кампаний с оплатой за клик).

Маркетинг в поисковых системах (SEM) представляет собой практику разработки, запуска и оптимизации рекламных кампаний в поисковых системах. Он отличен от SEO. Это отличие проще всего изобразить как разницу между платным и бесплатным приоритетами в результатах поиска.

SEM фокусируется больше на известности, чем на релевантности. Разработчикам веб-сайтов рекомендуется относиться к SEM как к тому, что имеет с первостепенную важность с учетом видимости, так как большая часть из них переходит к основным спискам своего поиска.

Успешная интернет-маркетинговая кампания может также зависеть от создания (в целях привлечения и убеждения интернет-пользователей) высококачественных веб-страниц, настройки аналитических программ, дающих владельцам веб-сайтов возможность оценивания результатов и повышения коэффициентов конверсии веб-сайтов.

Год 2015-й (ноябрь). Это было время опубликования Google (для общественности) полной 160-страничной версии своих «Руководств по оценке качества поиска», в которых было показано смещение его акцента в сторону «полезности» для пользователя и мобильного локального поиска. В последние годы рынок мобильных устройств продемонстрировал резкий рост, обогнав в использовании настольные компьютеры.

В 2016-м году (в октябре) StatCounter (когда им были проанализированы веб-сайты в количестве 2,5 миллиона) обнаружил, что 51,3% страниц были загружены с помощью мобильных устройств [1].

Google – это одна из компаний, ориентирующаяся на высокую популярность мобильного использования. Она поощряет веб-сайты использовать свою консоль поиска Google, тест на совместимость с мобильными устройствами, позволяющий компаниям сопоставлять свои веб-сайты с результатами рассматриваемого поисковика и определять, насколько удобными их веб-сайты являются для пользователей.

Чем ближе расположение ключевых слов друг к другу, тем более высокое их ранжирование на основе ключевых терминов.

SEO способно на обеспечение адекватной отдачи от инвестиций. Однако поисковым системам не производят оплату за органический поисковый трафик, их алгоритмы – изменяющиеся, и нет никаких гарантий на постоянство. При отсутствии гарантий и наличия неопределенности, в значительной мере зависящий от трафика поисковых систем, бизнес может столкнуться с несением больших убытков при прекращении привода поисковиками посетителей на их интернет-ресурсы.

Поисковые системы могут пойти на изменение своих алгоритмов. Это способно оказать влияние на рейтинг веб-сайта в поисковых системах, что может привести к серьезной утрате трафика.

Генеральный директор

Google Эрик Шмидт сказал, что [1]:

«в 2010 году компания Google внесла более 500 изменений в алгоритмы – почти 1,5 в день.

Операторы веб-сайтов считают мудрой деловой практикой практику освобождения от зависимости от трафика с поисковых систем. В дополнение к доступности с точки зрения поисковых роботов для поисковой оптимизации доступность веб-сайтов для пользователей становится все более значимой.

Международные рынки

Методы оптимизации являются четко настроенными на доминирующие поисковые системы на целевом рынке. Подобно рыночным долям в области конкуренции рыночные доли поисковых систем варьируются от рынка к рынку.

Год 2003-й был годом заявления Дэнни Салливана, что [1]:

«на Google приходится около 75% всех поисковых запросов».

Согласно данным по состоянию на 2007-й год [1]:

«На рынках за пределами США доля Google часто больше, и Google остается доминирующей поисковой системой в мире»

Согласно данным по состоянию на 2006-й год [1]:

«доля Google на рынке Германии составляла 85—90%. Хотя в то время в США существовали сотни SEO-фирм, в Германии их было всего около пяти».

По данным Hitwise [1]:

«на июнь 2008 года доля Google на рынке Великобритании составляла около 90%. Эта доля рынка достигается в ряде стран».

Согласно данным по состоянию на 2009-й год [1]:

«По состоянию на 2009 год существует лишь несколько крупных рынков, на которых Google не является ведущей поисковой системой».

В большинстве случаев, когда Google не лидирует на данном рынке, он отстает от локального игрока. Самые яркие примеры таких рынков [1]:

«Китай, Япония, Южная Корея, Россия и Чешская Республика, где соответственно Baidu, Yahoo! Япония, Naver, Яндекс и Seznam – лидеры рынка».

Для успешной поисковой оптимизации для международных рынков могут потребоваться: профессиональный перевод веб-страниц, регистрация доменного имени в домене верхнего уровня на целевом рынке и веб-хостинг с локальным IP-адресом. В остальных аспектах фундаментальные составляющие поисковой оптимизации практически одинаковы, независимо от языка.

Юридические прецеденты

Год 2002-й (семнадцатое октября). Это было время, когда [1]:

«компания SearchKing подала иск в Окружной суд Соединенных Штатов Западного округа Оклахомы против поисковой системы Google. SearchKing утверждала, что тактика Google по предотвращению спам-индексации представляла собой неправомерное вмешательство в договорные отношения».

Год 2003-й (двадцать седьмое мая). В данное время [1]:

«суд удовлетворил ходатайство Google об отклонении иска, поскольку SearchKing «не представил иск, по которому может быть предоставлена помощь».

Год 2006-й (март). В это время [1]:

«KinderStart подала иск против Google из-за рейтинга в поисковых системах. Веб-сайт KinderStart был удален из индекса Google до судебного процесса, а объем трафика на сайт упал на 70%».

Год 2007-й (шестнадцатое марта). Это было время, когда [1]:

«Окружной суд Соединенных Штатов Северного округа Калифорнии (округ Сан-Хосе) отклонил жалобу KinderStart без разрешения на внесение поправок и частично удовлетворил ходатайство Google о применении санкций по Правилу 11 против адвоката KinderStart, требуя от него оплатить часть судебных расходов»